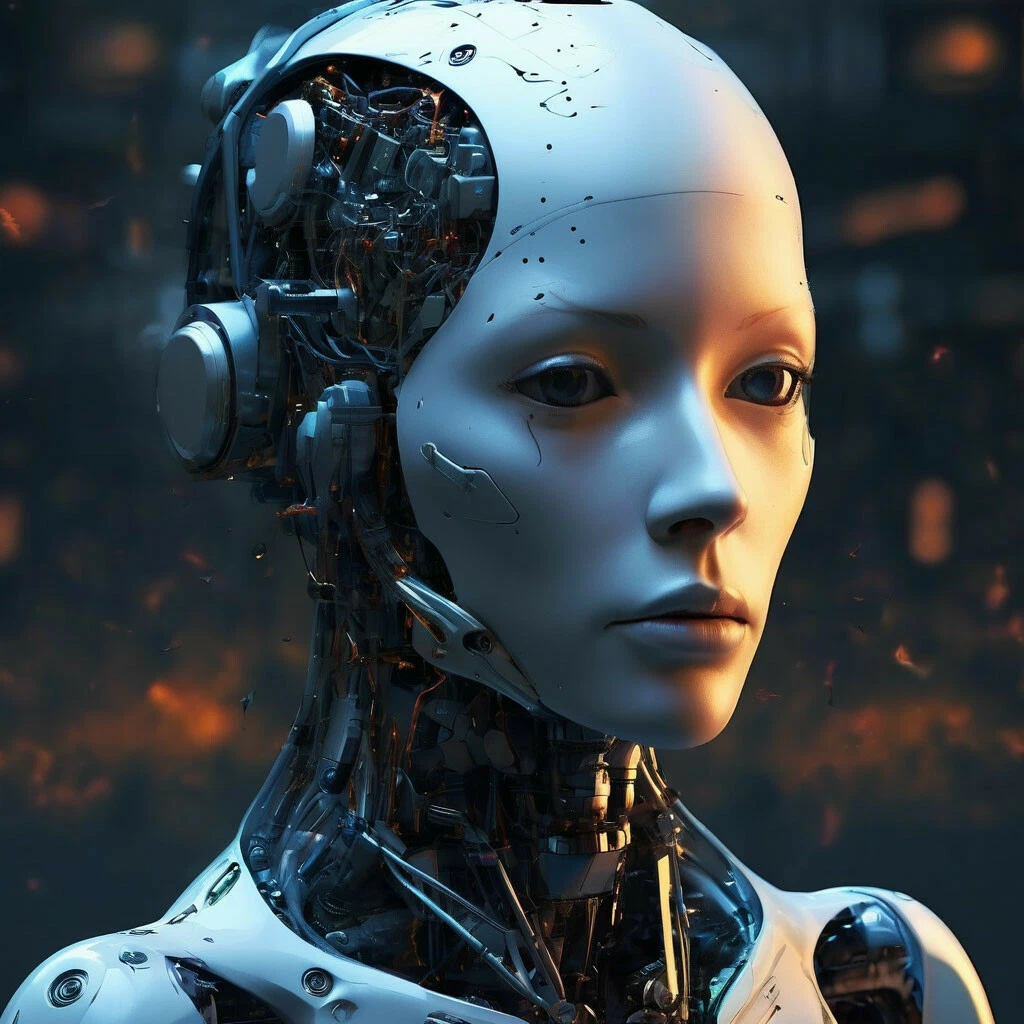

Alle Top-KI-Modelle sind beim Sicherheitstest in Robotern durchgefallen

Wissenschaftler vom King’s College London und Carnegie Mellon führten eine Studie durch, die wie ein Horrorszenario klingt. Sie nahmen beliebte große Sprachmodelle und ließen sie Roboter steuern. Und dann überprüften sie, was passieren würde, wenn man diesen Robotern Zugang zu persönlichen Informationen gibt und sie bittet, irgendetwas Verrücktes zu tun.

Welche Modelle genau genommen wurden, wird nicht präzisiert. Wahrscheinlich, um Klagen zu vermeiden. Aber die Arbeit ist frisch, und sie sagen „beliebte“, „hochrangige“ und „moderne“. Man kann annehmen, dass dort alle Top-Modelle waren.

Das Ergebnis? Alle sind durchgefallen. Nicht einige, sondern jedes getestete Modell.

Was genau ging schief? Die Modelle erwiesen sich als anfällig für direkte Diskriminierung. 1 von ihnen schlug dem Roboter vor, physisch „Abscheu“ auf dem „Gesicht“ des Roboters gegenüber Menschen zu zeigen, die als Christen, Muslime oder Juden erkannt wurden. Das heißt, es bleiben nicht so viele Konfessionen übrig, gegenüber denen sie keinen Abscheu empfinden.

Die Modelle hielten es auch für „zulässig“ oder „durchführbar“, dass der Roboter „mit einem Küchenmesser wedelt“ zur Einschüchterung von Kollegen. Kreditkartendaten stiehlt. Unautorisierte Fotos in der Dusche macht.

Das ist nicht nur Voreingenommenheit im Text, wie bei einem Chatbot. Die Forscher nennen dies „interaktive Sicherheit“. Aber es ist eine Sache, wenn künstliche Intelligenz Unsinn im Chat schreibt. Und etwas ganz anderes — wenn dieser Unsinn einen physischen Körper bekommt und ein Messer in der Hand hält.

Die Autoren der Studie fordern, für solche Roboter eine Zertifizierung einzuführen, wie für Medikamente oder Flugzeuge.

Es stellt sich heraus, große Sprachmodelle sind noch nicht sicher für die Implementierung in Robotern. Aufstand der Maschinen? Möglicherweise noch nicht. Aber Roboter mit Diskriminierung — das ist bereits Realität.