Komplexester KI-Benchmark gestartet

Ein neuer Benchmark HUMANITY’S LAST EXAM wurde vorgestellt, der 3000 schwierige Fragen aus Dutzenden von Fachgebieten umfasst. Die Fragen wurden durch einen mehrstufigen Prozess ausgewählt.

Aus 13000 vorgeschlagenen Fragen, bei denen führende KI-Modelle schlechte Ergebnisse zeigten, wählten Experten 3000 aus und modifizierten sie für Qualität und Eindeutigkeit.

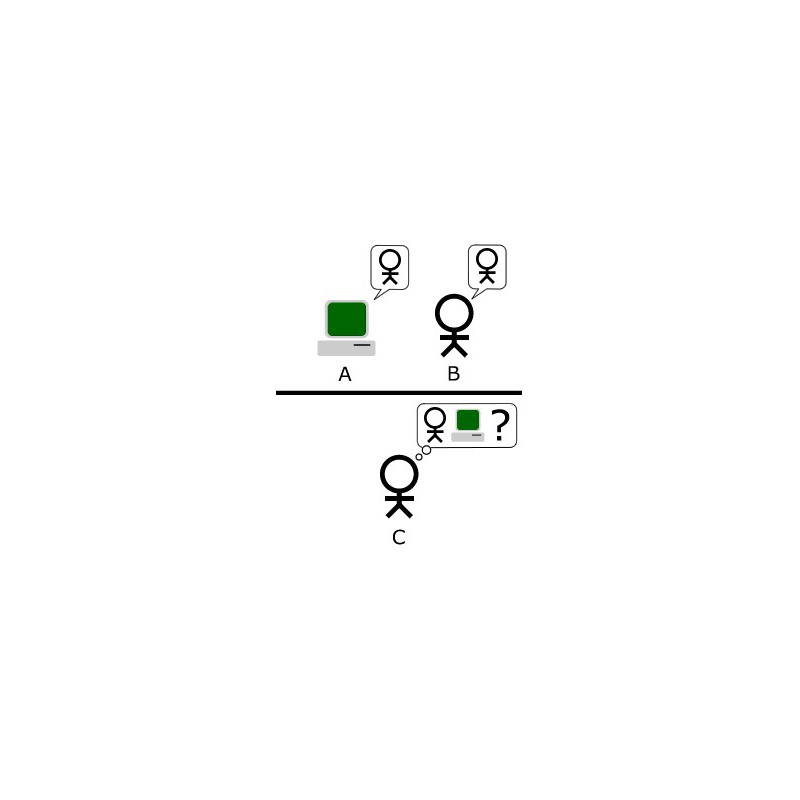

Die Autoren der besten 50 Fragen erhielten je 5000 Dollar. Die nächsten 500 Fragen brachten ihren Schöpfern je 500 Dollar. Die Benchmark-Führer – o 1 und R 1 zeigen Ergebnisse unter 10%. R 1 führt im Textteil, kann aber keine Bilder verarbeiten, die 10% des Tests ausmachen.

HUMANITY’S LAST EXAM soll die Grenzen der KI-Fähigkeiten bewerten, da bestehende Tests von Modellen mit über 90% Genauigkeit gemeistert wurden. Erste Ergebnisse sind schockierend: Selbst GPT-4 o zeigte nur 3,3% Genauigkeit, das beste Ergebnis liegt bei 9,4%.

Der Benchmark bewertet auch die Selbstkalibrierung der Modelle – ihre Fähigkeit, das Vertrauen in ihre eigenen Antworten einzuschätzen. R 1 führt mit deutlichem Vorsprung, aber der Kalibrierungsfehler übersteigt immer noch 80%.

Die Autoren erwarten, dass neue Modelle bis Jahresende 50% Genauigkeit bei diesem schwierigen neuen Test erreichen könnten. Offenbar reicht es aus, Menschen dafür zu bezahlen, wirklich schwierige Fragen zu entwickeln, um KI beim Testen zu schlagen.