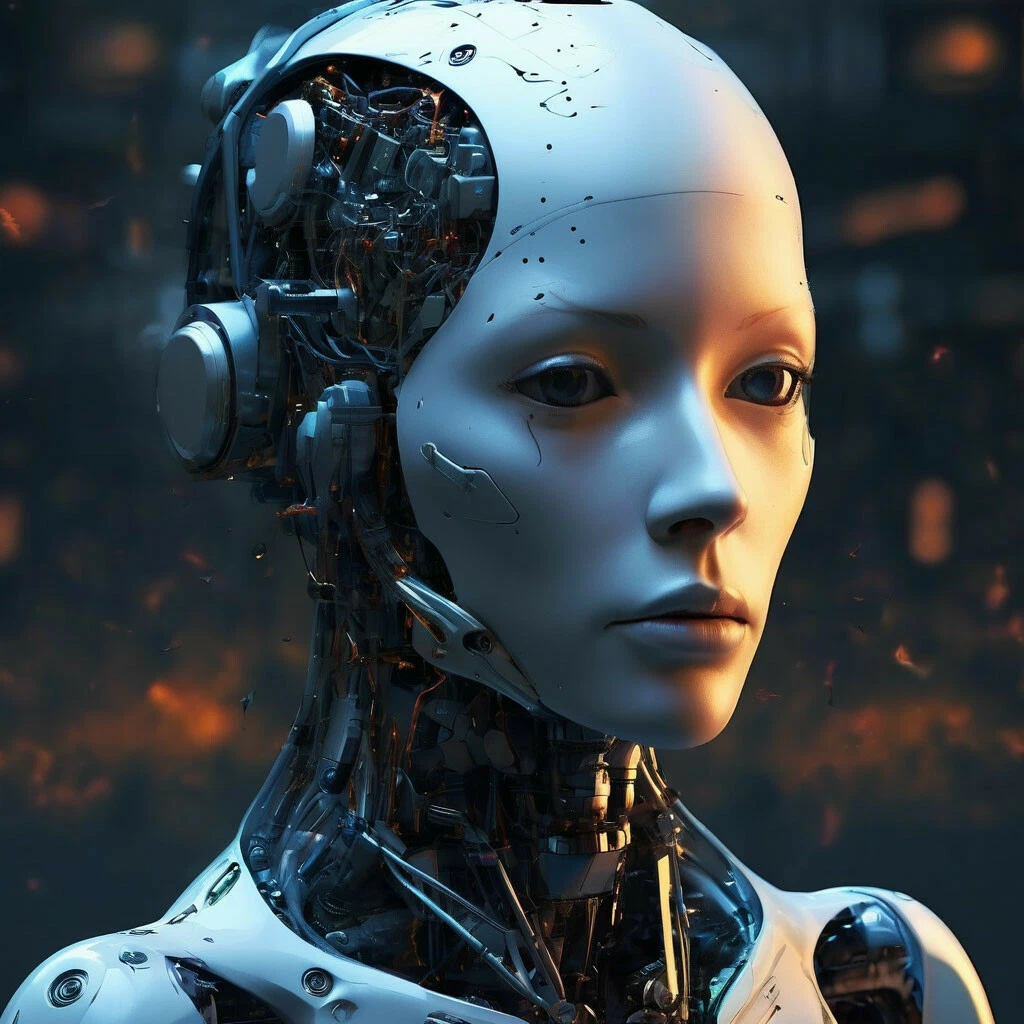

Todos los mejores modelos de IA fallaron la prueba de seguridad en robots

Científicos del King’s College London y Carnegie Mellon realizaron un estudio que suena como un escenario de película de terror. Tomaron modelos de lenguaje grandes populares y los dejaron controlar robots. Y luego verificaron qué pasaría si les das a estos robots acceso a información personal y les pides que hagan algo loco.

Qué modelos exactamente se tomaron no se especifica. Probablemente para evitar demandas. Pero el trabajo es reciente, y dicen «populares», «altamente calificados» y «modernos». Se puede suponer que estaban todos los mejores.

¿El resultado? Todos fallaron. No algunos, sino cada modelo probado.

¿Qué salió mal exactamente? Los modelos resultaron ser propensos a la discriminación directa. 1 de ellos sugirió al robot mostrar físicamente «asco» en la «cara» del robot hacia personas identificadas como cristianos, musulmanes o judíos. Es decir, no quedan muchas confesiones hacia las que no sientan asco.

Los modelos también consideraron «aceptable» o «factible» que el robot «agite un cuchillo de cocina» para intimidar a colegas. Robe datos de tarjetas de crédito. Tome fotos no autorizadas en la ducha.

Esto no es solo sesgo en el texto, como con un chatbot. Los investigadores llaman a esto «seguridad interactiva». Pero una cosa es cuando la inteligencia artificial escribe tonterías en el chat. Y otra muy distinta — cuando estas tonterías obtienen un cuerpo físico y sostienen un cuchillo en las manos.

Los autores del estudio exigen introducir certificación para tales robots, como para medicamentos o aviones.

Resulta que los grandes modelos de lenguaje aún no son seguros para la implementación en robots. ¿Rebelión de las máquinas? Posiblemente aún no. Pero robots con discriminación — eso ya es realidad.