Le benchmark le plus complexe pour l’IA est lancé

Un nouveau benchmark HUMANITY’S LAST EXAM a été présenté, comprenant 3000 questions difficiles dans des dizaines de domaines. Les questions ont été sélectionnées par un processus multi-étapes.

Parmi 13000 questions proposées où les principaux modèles d’IA montraient de mauvais résultats, les experts en ont sélectionné 3000, les modifiant pour assurer qualité et clarté.

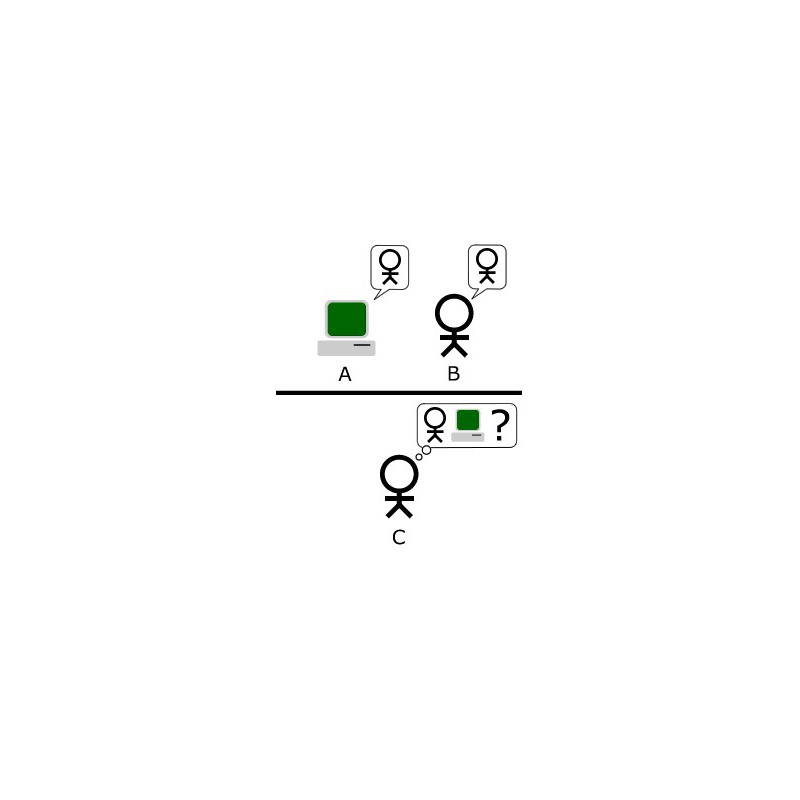

Les auteurs des 50 meilleures questions ont reçu 5000 dollars chacun. Les 500 questions suivantes ont rapporté 500 dollars à leurs créateurs. Les leaders du benchmark – o 1 et R 1 montrent des résultats inférieurs à 10%. R 1 mène la partie textuelle mais ne peut traiter les images, représentant 10% du test.

HUMANITY’S LAST EXAM vise à évaluer les limites des capacités de l’IA, les tests existants ayant été maîtrisés par des modèles avec plus de 90% de précision. Les premiers résultats sont choquants : même GPT-4 o n’a montré que 3,3% de précision, le meilleur résultat étant de 9,4%.

Le benchmark évalue aussi l’auto-calibration des modèles – leur capacité à évaluer la confiance dans leurs propres réponses. R 1 mène avec une avance significative, mais l’erreur de calibration dépasse toujours 80%.

Les auteurs s’attendent à ce que les nouveaux modèles puissent atteindre 50% de précision sur ce nouveau test difficile d’ici la fin de l’année. Apparemment, pour battre l’IA aux tests, il suffit de payer des gens pour créer des questions vraiment difficiles.