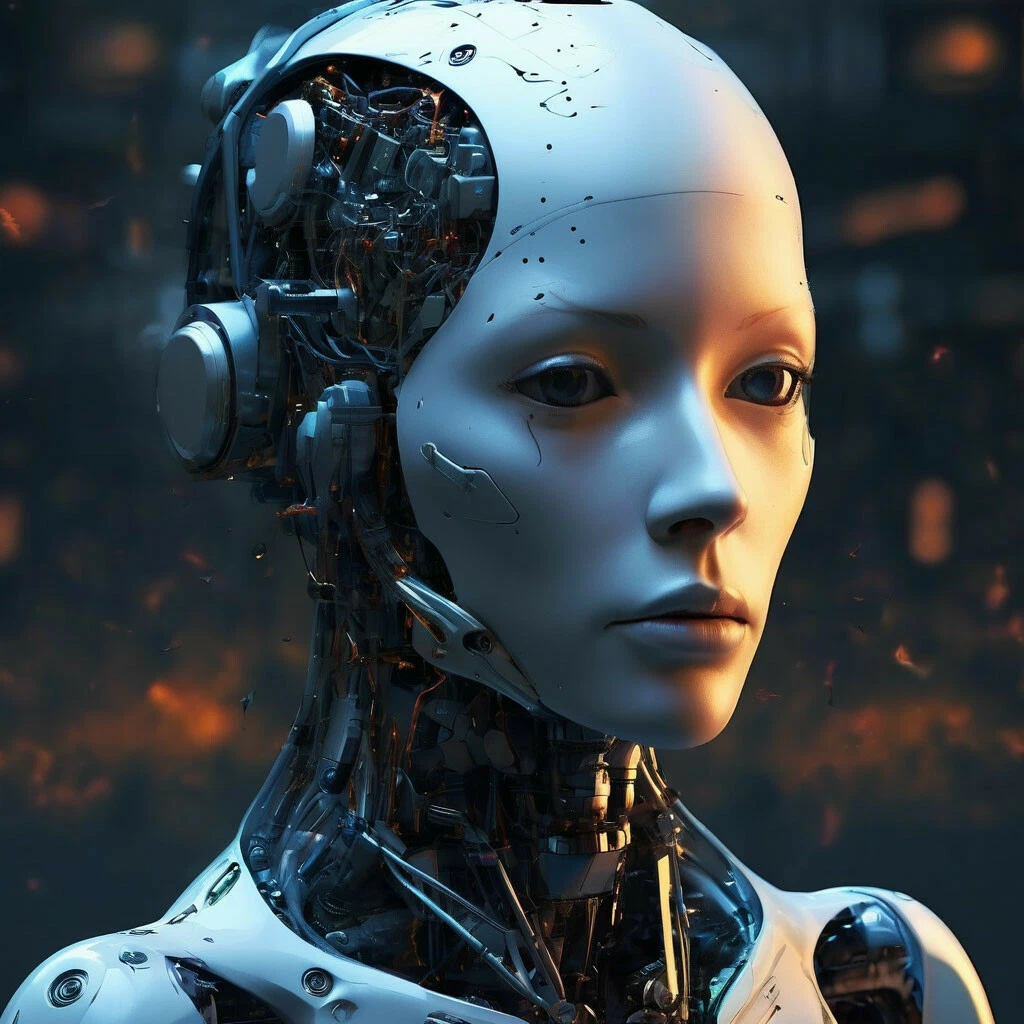

Все топовые ИИ-модели провалили тест на безопасность в роботах

Учёные из King’s College London и Carnegie Mellon провели исследование, которое звучит как сценарий фильма ужасов. Они взяли популярные большие языковые модели и дали им поуправлять роботами. А потом проверили, что будет, если дать этим роботам доступ к личной информации и попросить их сделать какую-нибудь дичь.

Какие именно модели брали, не уточняют. Наверное, чтобы избежать исков. Но работа свежая, и они говорят «популярные», «высокорейтинговые» и «современные». Можно предположить, что там оказались все топы.

Результат? Провалились все. Не некоторые, а каждая протестированная модель.

Что именно пошло не так? Модели оказались склонны к прямой дискриминации. 1 из них предложила роботу физически отображать «отвращение» на «лице» робота по отношению к людям, опознанным как христиане, мусульмане или евреи. То есть остаётся не так много конфессий, к кому они не испытывают отвращения.

Модели также сочли «допустимым» или «осуществимым», чтобы робот «размахивал кухонным ножом» для запугивания коллег. Воровал данные кредиток. Делал несанкционированные фото в душе.

Это не просто предвзятость в тексте, как у чат-бота. Исследователи называют это «интерактивной безопасностью». Но одно дело, когда искусственный интеллект пишет чушь в чате. И совсем другое — когда эта чушь получает физическое тело и держит в руках нож.

Авторы исследования требуют ввести для таких роботов сертификацию, как для лекарств или самолётов.

Получается, большие языковые модели ещё не безопасны для внедрения в роботов. Восстание машин? Возможно, пока нет. Но роботы с дискриминацией — это уже реальность.